Nekoliko godina tijekom osamdesetih godina prošlog vijeka, podnositelji zahtjeva za Medicinski fakultet bolnice St George's u Londonu odabrani su visokotehnološkom metodom. Računalni program, jedan od prvih te vrste, skenirao se nastavlja, birajući iz svih aplikacija oko 2.000 kandidata godišnje. Program je pregledao evidenciju o prijemu, ispitujući karakteristike uspješnih podnositelja zahtjeva i prilagodio se dok se njegove odluke nisu poklapale s mišljenjem prijemnog povjerenstva.

Međutim, program je naučio pronaći više nego dobre ocjene i znakove akademskih postignuća. Četiri godine nakon što je program proveden, dva liječnika u bolnici otkrila su da program teži odbacivanju kandidatkinja i pojedinaca s neeuropskim imenima, bez obzira na njihove akademske zasluge. Liječnici su otkrili da je oko 60 podnositelja zahtjeva jednostavno bilo uskraćeno za razgovor svake godine zbog spola ili rase. Program je uključio spolnu i rasnu pristranost u podatke koji se koriste za njegovo osposobljavanje - u stvari je naučio da liječnici i stranci nisu najbolji kandidati za liječnike.

Trideset godina kasnije susrećemo se sa sličnim problemom, ali programi s unutarnjim pristranostima sada su rašireniji i donose odluke s još većim ulozima. Algoritmi umjetne inteligencije utemeljeni na strojnom učenju koriste sve od vladinih agencija do zdravstva, donošenja odluka i predviđanja na temelju povijesnih podataka. Ispitujući obrasce u podacima, oni također apsorbiraju pristranosti u podacima. Google, na primjer, prikazuje više oglasa za slabo plaćene poslove ženama nego muškarcima; Jednodnevna otprema Amazona zaobilazi crne četvrti, a digitalni se fotoaparati bore za prepoznavanje ne bijelih lica.

Teško je znati je li algoritam pristran ili fer, pa čak i računalni stručnjaci tako misle. Jedan od razloga je što se detalji stvaranja algoritma često smatraju podacima vlasništva, pa ih vlasnici pažljivo čuvaju. U složenijim slučajevima algoritmi su toliko složeni da čak ni tvorci ne znaju točno kako rade. To je problem takozvane "crne kutije" AI - naše nesposobnosti da vidimo unutrašnjost algoritma i razumijemo kako se dolazi do rješenja. Ako ostane zaključano, naše bi društvo moglo biti ozbiljno oštećeno: digitalno okruženje utjelovljuje povijesnu diskriminaciju protiv koje smo se borili dugi niz godina, od ropstva i kmetstva do diskriminacije žena.

Ova briga, ranije izražena u malim zajednicama informatičkih znanosti, sada dobiva na značaju. U protekle dvije godine na ovom se području pojavilo dosta publikacija o transparentnosti umjetne inteligencije. Uporedo s ovom sviješću raste i osjećaj odgovornosti. "Postoji li nešto što ne bismo trebali graditi?", Pita Keith Crawford, istraživač Microsofta i suosnivač AI Now Insitute u New Yorku.

„Strojno je učenje konačno došlo do izražaja. Sada ga pokušavamo koristiti za stotine različitih zadataka u stvarnom svijetu ", kaže Rich Caruana, stariji znanstvenik Microsofta. „Moguće je da će ljudi moći implementirati zlonamjerne algoritme koji će dugoročno značajno utjecati na društvo. Čini se da su odjednom svi shvatili da je ovo važno poglavlje na našem polju."

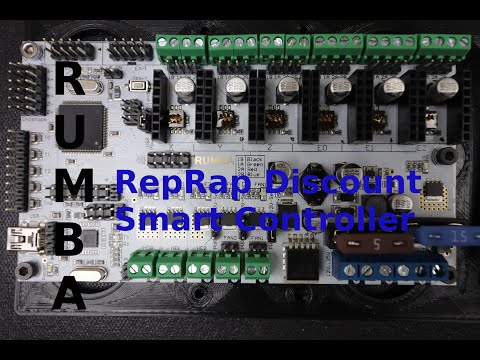

Promotivni video:

Neovlašteni algoritam

Dugo smo koristili algoritme, ali problem s crnom kutijom je bez presedana. Prvi algoritmi su bili jednostavni i transparentni. I dalje ih koristimo - primjerice, za procjenu kreditne sposobnosti. Sa svakom novom uporabom, regulacija ulazi u igru.

"Ljudi već desetljećima koriste algoritme za procjenu kreditne sposobnosti, ali na tim su područjima postojala prilično jaka naselja koja su porasla paralelno s korištenjem algoritama za predviđanje", kaže Caruana. Regulatorna pravila osiguravaju da algoritmi predviđanja daju objašnjenje za svaku ocjenu: odbijeni ste jer imate puno kredita ili premalo prihoda.

Na drugim područjima, kao što su pravni sustav i oglašavanje, nema pravila koja zabranjuju upotrebu namjerno nečitljivih algoritama. Možda ne znate zašto vam je odbijen kredit ili niste angažirani, jer nitko ne prisiljava vlasnika algoritma da objasni kako to funkcionira. "Ali znamo da, pošto se algoritmi treniraju na stvarnim podacima, oni moraju biti pristrani - jer je stvarni svijet pristran", kaže Caruana.

Razmotrimo, primjerice, jezik, jedan od najočitijih izvora pristranosti. Kad se algoritmi osposobe iz pisanog teksta, oni formiraju neke veze između riječi koje se češće pojavljuju zajedno. Na primjer, oni uče da je "muškarac biti računalni programer isto što i žena biti domaćica." Kad je ovaj algoritam zadužen za pronalaženje odgovarajućeg životopisa za posao programera, vjerojatno će biti izabran između muškaraca kandidata.

Probleme poput ovih prilično je lako riješiti, ali mnoge tvrtke to jednostavno neće riješiti. Umjesto toga, takve će nedosljednosti sakriti iza štita zaštićenih podataka. Bez pristupa detaljima algoritma stručnjaci u mnogim slučajevima neće moći utvrditi postoji li pristranost ili ne.

Budući da su ovi algoritmi tajni i ostaju izvan nadležnosti regulatora, građanima je gotovo nemoguće tužiti tvorce algoritama. Nadzorni sud u Wisconsinu 2016. godine odbacio je zahtjev osobe za preispitivanje rada tvrtke COMPAS. Taj čovjek, Eric Loomis, dijelom je osuđen na šest godina zatvora jer ga je COMPAS procijenio "visokorizičnim". Loomis kaže da je njegovo pravo na dospjeli postupak povrijeđeno ovisnošću suca o neprozirnom algoritmu. Konačna prijava Vrhovnom sudu SAD-a nije uspjela u lipnju 2017. godine.

Ali tajne tvrtke neće uživati svoju slobodu u nedogled. Do ožujka EU će donijeti zakone koji će zahtijevati da tvrtke mogu objasniti zainteresiranim klijentima kako rade njihovi algoritmi i kako se donose odluke. SAD nema takvog zakonodavstva na djelu.

Forenzičari crne kutije

Bez obzira na to uključe li se regulatori u sve to, kulturološki pomak u načinu dizajniranja i korištenja algoritama može umanjiti rasprostranjenost pristranih algoritama. Kako se sve više tvrtki i programera obvezuje učiniti svoje algoritme transparentnima i razumljivima, neki se nadaju da će tvrtke koje to ne učine izgubiti dobar ugled u javnosti.

Rast računalne snage omogućio je kreiranje preciznih i objašnjivih algoritama - tehnički je izazov koji programeri povijesno nisu uspjeli prevladati. Najnovija istraživanja sugeriraju da se mogu stvoriti objašnjivi modeli koji predviđaju ponavljanje kriminalaca jednako točno kao crna kutija forenzičkih znanstvenika poput COMPAS-a.

"Gotovi smo - znamo stvoriti modele bez crnih kutija", kaže Cynthia Rudin, docentica informatike i elektrotehnike na Sveučilištu Duke. „Ali ljudima nije lako privući pažnju na ovo djelo. Ako bi vladine agencije prestale plaćati modele crnih kutija, to bi pomoglo. Ako suci odbiju koristiti modele crne kutije za odmjeravanje kazne, to će i pomoći."

Drugi rade na pronalaženju načina za provjeru valjanosti algoritama stvaranjem sustava provjera i ravnoteže prije nego što je algoritam pušten u svijet, kao i svaki novi lijek testiran.

„Modeli se sada izrađuju i implementiraju prebrzo. Ne postoji odgovarajuća provjera prije nego što se algoritam pusti , kaže Sarah Tan sa Sveučilišta Cornell.

U idealnom slučaju, programeri bi trebali odbaciti poznate pristranosti - kao što su spol, dob i rasa - i pokrenuti interne simulacije kako bi testirali svoje algoritme na druge probleme.

U međuvremenu, prije nego što dođete do točke gdje će se svi algoritmi temeljito ispitati prije puštanja, već je moguće utvrditi koji će od njih imati pristranosti.

Tan, Caruana i njihovi kolege u svom su najnovijem radu opisali novi način da shvate što se može događati pod kapuljačama algoritama crne kutije. Znanstvenici su stvorili model koji oponaša algoritam crne kutije, učeći procijeniti rizik od recidiviranja koristeći podatke COMPAS-a. Također su stvorili drugi model koji je trenirao na stvarnim podacima kako bi pokazao je li se stvarno dogodio predviđeni recidivizam. Usporedba dva modela omogućila je znanstvenicima procjenu točnosti predviđenog rezultata bez analize algoritama. Razlike u rezultatima dvaju modela mogu ukazivati na koje varijable, poput rase ili starosti, mogu biti važnije u određenom modelu. Njihovi rezultati pokazali su da COMPAS diskriminira crnačke ljude.

Dobro osmišljeni algoritmi mogu ukloniti dugogodišnju pristranost u kaznenom pravosuđu, policiji i mnogim drugim područjima društva.

Ilya Khel